Ecouter l’émission sur France Culture

Peut-on composer une symphonie en ayant uniquement recours à l’intelligence artificielle ? Pas encore. Mais les progrès récents, et fulgurants, fascinent. Et préoccupent.

Début juin a soufflé comme un vent de « Beatlemania » : « Une intelligence artificielle a recréé la voix de John Lennon », « Un titre inédit des Beatles sortira cette année ». Depuis, Paul McCartney a mis les points sur les i : « Tout est réel », a rectifié l’ancien membre du quatuor, l’ « IA » utilisée, seulement, pour « nettoyer » de vieux enregistrements. Si les pastiches vocaux essaiment en ce moment, nous restons dans le domaine de l’imitation, du trucage : ce que les Anglais appellent le deep fake. Nous proposons d’interroger plutôt la création, la composition. Avec une question : l’IA, grâce aux progrès récents et fulgurants, peut-elle inventer de nouvelles formes musicales ?

« Avec un programme, nous lui donnons la vie »

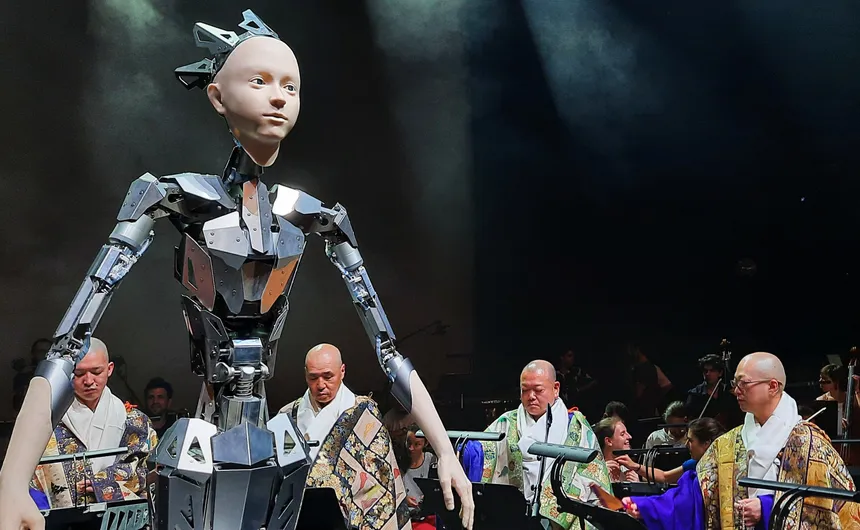

C’est l’histoire du compositeur qui murmurait à l’oreille… de l’intelligence artificielle. Il s’appelle Keiichiro Shibuya, il est Japonais, et a posé son piano au mois de juin au Théâtre du Châtelet, à Paris. « Je travaille depuis longtemps avec l’intelligence artificielle, pour écrire des paroles, notamment. J’ai commencé à en créer en utilisant ChatGPT 2, et aujourd’hui ChatGPT 4 », raconte-t-il. Une console, des écrans d’ordinateur… Keiichiro Shibuya peaufine une création mondiale, Android Opera Mirror, qui met en scène une singulière diva : « Moi et mon équipe avons élaboré un androïde, qui peut improviser en temps réel. L’androïde, prénommé Alter, serait un objet vide s’il n’était pas équipé d’un programme. Mais avec un programme, nous lui donnons la vie. »

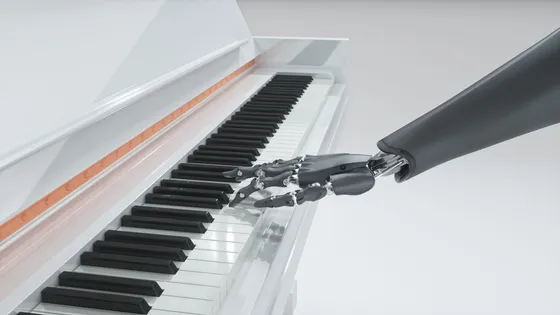

Et Alter est équipé d’un programme très complexe. Nourri, aussi, d’une énorme quantité de musiques : « Il est assez facile de créer des mélodies grâce à l’intelligence artificielle. Par exemple, il m’arrive de jouer du piano. Alter écoute, improvise une mélodie, et il m’arrive de les réutiliser. » Cela pose d’ores et déjà des questions d’ordre moral et éthique : Alter pourrait-il être considéré comme un artiste ? Keiichiro Shibuya, en tout cas, est enthousiaste : « Je pense que cela peut même être une chance, une opportunité de créer des choses nouvelles. De plus, je suis beaucoup plus à l’aise quand je travaille avec l’intelligence artificielle, peut-être même plus qu’avec d’autres humains. »

Des progrès sidérants

La création Android Opera Mirror est née de la collaboration entre l’homme et l’intelligence artificielle. Mais l’IA peut-elle composer de la musique toute seule ? Pour le savoir, direction l’Institut de recherche et coordination acoustique/musique (Ircam). Ce dernier élabore en ce moment des algorithmes de composition très pointus qui peuvent, même une fois lancés, se passer de l’intervention humaine. « Nous opérons avec un logiciel nommé Max, dans lequel tournent huit agents, qui interagissent ensemble », explique Manuel Poletti, réalisateur en informatique musicale, que nous rejoignons dans l’un des studios de l’Ircam. Des « agents », comme s’il s’agissait de véritables êtres humains ? « Tout à fait, ce sont vraiment des personnages qui ont leur propre vie, que l’on découvre en permanence. »

Nous écoutons deux algorithmes « dialoguer ». L’un produit des pizzicati de contrebasse, l’autre des accords de guitare. « Les deux sont en train de jouer ensemble en mode ‘solo’, sans interaction humaine. Le logiciel est en train de recombiner une musique déjà existante d’une manière inédite, avec une cohérence mélodique, harmonique », étaye Mikhail Malt, chercheur au sein de l’équipe « Représentations musicales » de l’Ircam.

À l’oreille, cela sonne encore un peu expérimental. Mais les progrès sont galopants et Gérard Assayag, directeur de recherches à l’Ircam, est aux premières loges pour le constater : « Nous commençons à voir émerger des systèmes auxquels nous pouvons donner un ‘prompt’, c’est-à-dire une instruction en langage naturel, qui vont générer des formes musicales. Il y a des démonstrations qui sont déjà très impressionnantes, mais d’ici très peu de temps, cela va se développer considérablement ». Concrètement, une intelligence artificielle pourra-t-elle bientôt composer une symphonie à partir d’un prompt ? « Elle pourra en tout cas composer des fragments significatifs de ce qui pourrait ressembler à une symphonie. Cela sera peut-être suffisant pour illustrer une scène dans un film ou dans une série, ce qui pose des préoccupations d’ordre économique. »

Menace sur l’industrie musicale ?

La question économique, justement, est au coeur des préoccupations au Centre national de la musique (CNM) qui observe et soutient la filière musicale. Les programmes les plus performants sont pour le moment entre les mains des gros acteurs de la tech, comme Google, car de gros moyens sont nécessaires pour créer ces modèles, puis les entraîner. Mais ils auront sans doute tendance à se démocratiser dans les prochaines années. « Il y a des opportunités à saisir pour la création musicale, l’intelligence artificielle peut être une formidable aide à la composition, à la création, à l’écriture », mais « les risques sont vertigineux, car des intérêts économiques peuvent trouver formidable de générer de la valeur et des revenus sans devoir les distribuer à des artistes et à des personnes physiques », souligne Jean-Philippe Thiellay, le président du CNM : « S’il n’y a pas un compositeur ou un interprète, il n’y a pas d’aides du Centre national de la musique, nous sommes catégoriques sur ce point. De la musique composée uniquement par ordinateur ne nous paraît pas conforme à la défense de la diversité, qui est une diversité humaine. »

Ces préoccupations poussent les acteurs de distribution et d’écoute de la musique à prendre des mesures. Début juin, la plateforme française de streaming Deezer a ainsi indiqué avoir mis au point une technologie lui permettant d’identifier les chansons clonant les voix de stars de la musique via l’intelligence artificielle. « Notre objectif est d’éliminer les contenus illégaux et frauduleux, d’accroître la transparence et de développer un nouveau système de rémunération où les artistes professionnels sont récompensés pour la création de contenus de valeur », pointait dans un communiqué le PDG de Deezer, Jeronimo Folgueira.

« Spotify, de son côté, à retiré des dizaines de milliers de titres parce qu’ils avaient été manipulés par l’intelligence artificielle », ajoute Jean-Philippe Thiellay, qui interroge les limites de l’intelligence artificielle : « Une IA aurait-elle pu inventer l’accord de Tristan, dans Tristan et Isolde de Wagner ? Une IA aurait-elle pu inventer les premiers morceaux de hip-hop ou le morceau qui ouvre le dernier album de Bob Dylan, qui dure 17 minutes ? Autrement dit, peut-on apprendre à la machine à être disruptive ? »

Oui, probablement, estime Shlomo Dubnov, professeur à l’Université de Californie – San Diego, spécialiste des liens entre musique et intelligence artificielle. Mais ce jour n’est selon lui pas encore arrivé. « Beaucoup de ces interactions aboutissent à la création de contenus crédibles. Un objet sonore, puis un autre objet sonore… Mais si l’on creuse un peu, nous nous rendons compte qu’il n’y a rien derrière, à part une recomposition à partir de motifs déjà existants », analyse le chercheur : « Cela peut créer des motifs incroyables, des séquences qui semblent musicales, mais qui n’ont pas de sens profond. L’algorithme n’a pas de morale, ne sait pas ce que c’est que d’être triste ou heureux. À un certain point, il faut creuser plus profondément, se poser la question de l’action créative. Et cette action doit être accompagnée d’une personnalité. »

Musique artificielle, émotion réelle

Alter, l’androïde, sème le trouble lorsqu’il déploie sa silhouette sur la scène du théâtre du Châtelet. Corps insectoïde fait de métal, mais visage humain, en latex, avec des yeux expressifs et les paupières qui clignent. La créature est entourée d’un chœur très particulier : cinq moines bouddhistes japonais descendus du mont Koya, une montagne sacrée, qui dialoguent – rencontre improbable – avec l’intelligence artificielle. « Sur scène, il y a des éléments si différents : l’androïde, les humains, le chant – qui date de 1 200 ans – et la musique électronique. Nous pensons que ce sont des choses qui ne devraient pas s’accorder à première vue, mais nous arrivons à nous harmoniser. Nous sommes tous des entités vivant sur cette Terre », nous confie le moine Eizen Fushiwara.

L’androïde s’essaie même à la direction, chef, le temps d’une représentation, de l’orchestre Appassionato. « Les mouvements ne sont pas exactement ceux d’un chef d’orchestre. Par contre, il ou elle nous regarde : les yeux bougent, c’est assez perturbant », décrit Camille Garant, violoniste. La musicienne est impressionnée par l’androïde, mais n’est pas trop inquiète : « D’ici à être remplacés par des robots, cela va prendre du temps. Je ne dis pas que ce serait impossible, mais je pense que l’on ne pourra jamais retrouver l’âme humaine et les idées humaines dans le jeu d’un instrument. » Une technologie au service d’une émotion musicale nouvelle qui interroge les limites, mais surtout les possibles, d’une intelligence artificielle devenue furieusement réelle.